“コードを書きたくなる”自動運転を見据、AIを活用したドライビングシミュレーター

ソニー・ホンダモビリティ(以下、SHM)が開発する「AIを活用したドライビングシミュレーター(以下、シミュレーター)」は、従来のドライビングシミュレーターとは考え方が根本的に異なる、“ドライバー=AI”のためのまったく新しいシミュレーターだ。

このシミュレーターは、ADAS及び自動運転技術に必要な、クルマが外部環境を認識する能力を飛躍的な速度で高めるだけでなく、車内インターフェースの進化も促す。360°スクリーンで外界をCG描画するロボットのコックピットのような車内、あるいはクリエイターの共創プラットフォームとなるクルマとなる未来も、もはやSFや空想上のものではなくなるかもしれない。

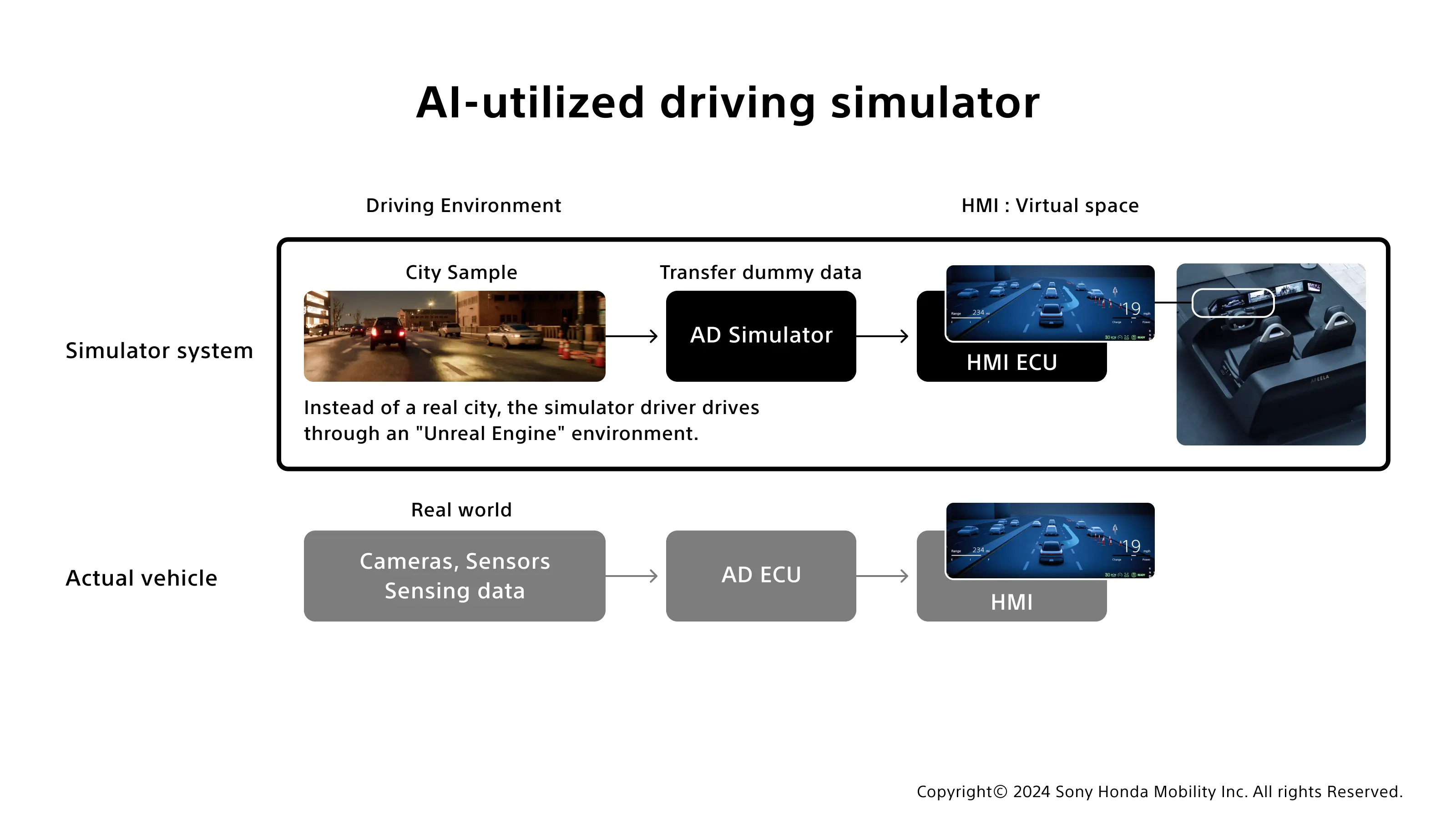

クルマの「認知能力」を、仮想空間で積み重ねる

運転操作にヒトが介在するレベル3までの自動運転の大きな特徴は、情報処理とクルマからヒトへの情報伝達の複雑さにある。このドライバーへの情報伝達はHMI ECUを介して車室内の各種HMIコンポーネントを用いて行われるが、ここで重要なのは、AD ECU内のAIが処理してHMI ECUに送信する、外部環境や状況、オブジェクトなどの正確な認識情報である。SHMでは画像認識に有効とされる「Vision Transformer(ViT)」を用いた認識器を独自開発し、この認識処理の性能を従来より飛躍的に向上させているが、CES®2024で発表したように、それらAIを使った機械学習システムにおいては、QualcommのSnapdragon® Ride™ SoCが貢献している。

しかし、オブジェクトや環境の無数の組み合わせによって成り立つ現実世界の車外環境の高度な認識の実現は、多くの時間と開発コストも要する。現実世界でのシミュレーションは、AIを実現する上で重要な学習パターンの数もサイクルも限られており、公道で実車テストを行うハードルも高い。AD ECUの動作を確立してからその先の開発を積み上げていくのでは時間があっても足りないのだ。その課題を解決し、シミュレーションがHMIの開発にも活かせるよう開発したのが『AIを活用したドライビングシミュレーター』である。

無限のシュミレーションパターンで、さらなる安全を実現

このシミュレーターは、Epic Gamesのゲームエンジン「Unreal Engine 5(以下、UE)」を用いて、実世界に近い外的環境を仮想空間上につくり出し、新たなユーザー体験をつくり出すためのシミュレーターだ。

都市の3Dマップ(City Sample)をベースにしてコンピュータ上に仮想空間を構築し、車両はその仮想空間を走行。本来物理的なセンサーデバイスから送られた情報をもとに認識処理を行うAD ECUの代わりに、仮想空間で処理した認識情報を用いて、シミュレーターに接続された実車に搭載されるものと同一のHMI ECUに送信し、グラフィカルな環境表現を実現する。

このシミュレーターの大きなポイントは、オブジェクトの配置や挙動、道路状況、天候、さらには雨でセンサー類に水滴が付いてぼやけるといったことまで、絶えず変化する環境をリアルタイムかつ無限のパターンで生成し、実世界に限りなく近い仮想空間のなかでシミュレーションを行えることだ。

それによって、AIのトレーニングデータの蓄積とフィードバックループのサイクルを圧倒的な速さで回すことが可能になる。加えて、これらのシミュレーションデータをAD ECUにインプットすることで、認識器や経路計画器といったインターフェースの開発へと広げることもできる。こうした短い期間でより精度の高い自動運転技術が開発可能になることで、より安全性を高めることにもつながるはずだ。

遠隔運転操作の可能性も。 シミュレーターが創出する体験

このシミュレーターは開発のみならず、ユーザーの新たな車内体験創出を加速させていくだろう。AD ECUの検証・開発と並行し、ユーザーとの接点となるHMI側の体験向上により注力し、ユーザーが本当に望むインターフェースデザインを迅速にプロトタイプしていくことが可能になるからだ。

HMI ECUでは、AD ECUを代替するコンピュータから3Dマップやセンサー画像、オブジェクトの情報、認識情報を直接取得し、それらをもとに、HMI ECUに同じく搭載されたUEがリアルタイムに3Dモデリングを行って3次元の仮想空間を構築。その中でUE上の仮想の車載カメラが撮影したものが車内ディスプレイ上のナビゲーションシステムなどで描画される。

また、UEと先端HMI ECUのテクノロジーを活用して、リアルタイムで、かつ正確に周辺世界を3Dデータ化し、カメラスルーと同等レベルのリッチな仮想の立体空間を描画することによって、ナビゲーションやAD/ADASの視覚効果にとらわれないポテンシャルを秘めている。

ロボットのコックピットのように、窓がなくなったとしても外界の状況をすべて3Dで中のパイロットに届ける、あるいはHMIで再現された仮想空間にヘッドマウントディスプレイを接続して遠隔で運転できるような、ワクワクする未来も可能になるかもしれない。このシミュレーターは、こうした車内インターフェースの未来を拡張する開発をシミュレートするためのものでもあるのだ。

これ以上ない、“コードを書きたくなる”環境

このシミュレーターの技術によって、様々なクリエイターたちが関与する共創プラットフォームを生み出すことも期待できる。多種多様なセンサー情報や3D都市モデルを保持するAFEELAは、エンジニアにとってはこれ以上ない“コードを書きたくなる”環境だ。よりユーザーに合ったカスタマイズが可能で、かつ楽しい体験ができるインターフェースアプリケーションを開発可能になるかもしれない。

従来、センサーデータはあくまでもAD/ADASを実現するためのものだった。しかし、スマートフォンがその用途を押し広げたように、AFEELAにおいても、位置情報や多くのセンサーによる外部環境の認識結果を幅広いアプリケーション開発に活用されていくだろう。もちろん、開発難易度は上がるわけであるが、このシミュレーターを用いることで効率的に開発していくことができれば、私たちも想像していない新しいユーザー体験が生まれていくはずだ。

Interviewer: Takuya Wada

Writer: Asuka Kawanabe

Related